BPR: Bayesian Personalized Ranking from Implicit Feedback 리뷰

논문 링크 : https://arxiv.org/ftp/arxiv/papers/1205/1205.2618.pdf

코드 링크 : https://github.com/benfred/implicit

해당 논문은 2009년도에 작성되었습니다.

UAI 2019 - Association for Uncertainty in Artificial Intelligence 라는 AI 컨퍼런스에 제출된듯 합니다.

이번 논문도 저번 논문처럼 implict 피드백에 대한 논문 입니다.

해당 논문은 새로운 모델을 생성했다기 보다는 기존 모델의 최적화 방법을 좀더 좋은 방법으로 고안하고 성능이 향상되었다는 것으로 보입니다.

contribution

1. We present the generic optimization criterion BPR-Opt derived from the maximum posterior estimator for optimal personalized ranking. We show the analogies of BPR-Opt to maximization of the area under ROC curve.

2. BPR-Opt를 최대화 하는데에 있어서 LearnBPR를 도입. 이는 bootstrap sampling을 통한 SGD를 사용.

3. LearnBPR를 기존의 SOTA 알고리즘에 대하여 적용.

4. 개인화 랭킹 모델에 대하여 BPR가 다른 모델들보다 좋다는 것을 보임.

또한 SVD, MF등 다른 알고리즘도 추가되어 있습니다.

코드 링크 : https://github.com/benfred/implicit

해당 논문은 2009년도에 작성되었습니다.

UAI 2019 - Association for Uncertainty in Artificial Intelligence 라는 AI 컨퍼런스에 제출된듯 합니다.

이번 논문도 저번 논문처럼 implict 피드백에 대한 논문 입니다.

해당 논문은 새로운 모델을 생성했다기 보다는 기존 모델의 최적화 방법을 좀더 좋은 방법으로 고안하고 성능이 향상되었다는 것으로 보입니다.

1. Introduction

해당 논문에서는 item recommendation을 주로 다룬다고 합니다. implicit한 데이터들이 얻기도 쉽고, 현실적인 데이터라고 언급하고 있습니다.contribution

1. We present the generic optimization criterion BPR-Opt derived from the maximum posterior estimator for optimal personalized ranking. We show the analogies of BPR-Opt to maximization of the area under ROC curve.

2. BPR-Opt를 최대화 하는데에 있어서 LearnBPR를 도입. 이는 bootstrap sampling을 통한 SGD를 사용.

3. LearnBPR를 기존의 SOTA 알고리즘에 대하여 적용.

4. 개인화 랭킹 모델에 대하여 BPR가 다른 모델들보다 좋다는 것을 보임.

2. Related Work

저번 논문처럼 kNN이 언급 되어 있습니다.또한 SVD, MF등 다른 알고리즘도 추가되어 있습니다.

3. Personalized Ranking

3.1 Formalization

U = 모든 유저

I = 모든 아이템

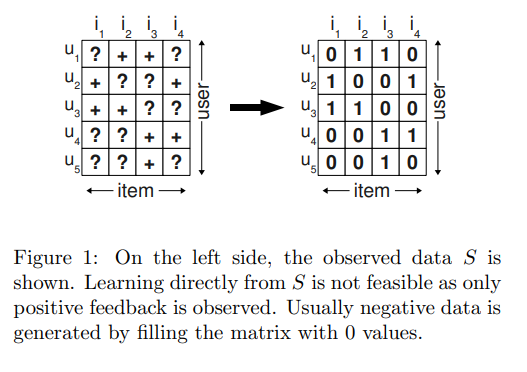

아래처럼 S ⊆ U ×I 인 S라는 Implicit 피드백이 존재.

아래 식에서의 >u를 찾는게 목표이고 그 >u는 다음과 같은 속성을 만족한다고 함.

이는 아마 아이템들과의 연관성을 나타내는 식인것 같음.

For convenience we also define:

이는 아마 아이템들과의 연관성을 나타내는 식인것 같음.

For convenience we also define:

3.2 Analysis of the problem setting

4. Bayesian Personalized Ranking (BPR)

4.1 BPR Optimization Criterion

목적은 아래와 같은 posterior를 최대화 하는게 목적. 쎄타는 파라미터.

유저와 아이템은 각각 서로서로 독립적이기에 preference를 다음과 같이 변환.

델타는 다음과 같음.

totality and antisymmetry를 통하여 다음과 같이 변환

아직까지는 완벽하게 랭킹이 보장되지 않아서 아래와 같이 개개인 preference 수식을 도입

중간 수식은 아래와 같이 시그모이드

4.1.1 Analogies to AUC optimization

아래와 같이 각 유저별 AUC를 정할 수 있다.

평균 AUC는 다음과 같다.

Ds를 기준으로 수식을 다시 쓰면 다음과 같다.

zu는 normalizing 상수

위의 Ds로 푼 수식은 BPR-Opt 수식과 유사한 점이 있다고 하며, AUC가 미분 불가능 하기 때문에 로그를 붙여서 처리한다고 한다.

4.2 BPR Learning Algorithm

4.3 Learning models with BPR

아래 내용은 MF, kNN을 통하여 모델로 사용한다는 내용으로 보인다. 내용은 추후 넣을 예정.

4.3.1 Matrix Factorization

4.3.2 Adaptive k-Nearest-Neighbor

5. Relations to other methods

다른 MF 알고리즘에 대하여 설명하는듯 한데 아래의 두 MF 알고리즘 자체에 대한 논문을 추후 봐야할것 같다. 볼게 많넹..

5.1 Weighted Regularized Matrix

Factorization (WR-MF)

5.2 Maximum Margin Matrix Factorization

(MMMF)

Improving maximum margin matrix factorization라는 논문에서 사용하였다고 하는 MMMF 알고리즘 사용

Improving maximum margin matrix factorization라는 논문에서 사용하였다고 하는 MMMF 알고리즘 사용

6. Evaluation

6.4 Non-personalized ranking

ㅇㅇ

댓글

댓글 쓰기